17/08/2019

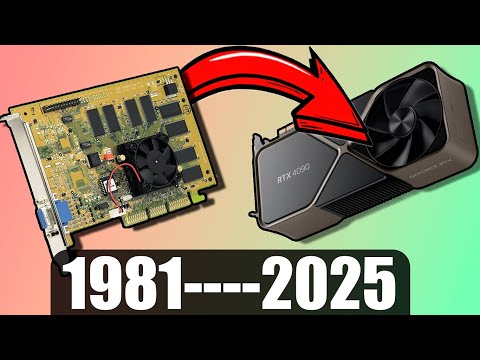

La historia de las tarjetas gráficas, también conocidas como tarjetas de video, es un maravilloso recorrido que abarca desde los humildes inicios de la representación de texto monocromático hasta la potencia gráfica que permite experiencias inmersivas en videojuegos y aplicaciones de alta demanda como la Inteligencia Artificial. Este viaje tecnológico ha estado marcado por innovaciones constantes que han impulsado la evolución de la informática y el entretenimiento.

Los Primeros Pasos: De la Impresora al Monitor

Si bien las primeras visualizaciones informáticas se realizaban a través de impresoras, el salto a los monitores a finales de los años 60 marcó el comienzo del desarrollo de las tarjetas gráficas. En sus inicios, estas tarjetas eran componentes integrados a la placa base, con funcionalidades limitadas a la salida de texto. A pesar de su simplicidad, representaban un avance crucial en la interacción con las computadoras.

Años 80: El Auge de las Computadoras Personales y las Consolas

El crecimiento exponencial de las computadoras personales y las videoconsolas en la década de los 80 impulsó la necesidad de tarjetas gráficas más sofisticadas. Aunque inicialmente setutorialn integradas en la placa base, su evolución fue incesante. Un hito importante fue la llegada en 1981 de la MDA (Monochrome Display Adapter), capaz de mostrar 25 líneas de 80 caracteres con una memoria RAM de 4 kB. Este dispositivo marcó el inicio de la representación visual más allá del simple texto.

El mismo año 1981 trajo consigo la CGA (Color Graphics Adapter) de IBM, introduciendo el color y los gráficos a las pantallas. Con 16 KiB de memoria VRAM, la CGA soportaba una paleta de 16 colores, pudiendo mostrar 4 simultáneamente. La posibilidad de conectar dos monitores representó un gran avance en la conectividad.

En 1982 apareció la HGC (Hercules Graphics Card), que permitía trabajar con dos páginas gráficas a una resolución de 720x348 píxeles. A pesar de combinar las características de la MDA y la CGA, su falta de soporte para color impidió su estandarización.

La Década de 1990: Hacia la Estándarización y el Aumento de la Potencia

La VGA (Video Graphics Array), presentada por IBM en 1990, marcó un antes y un después. Con 2 MB de memoria de video y soporte para 256 colores, la VGA se convirtió en un estándar ampliamente adoptado. A partir de este momento, la evolución de las tarjetas gráficas se aceleró significativamente.

En 1997, Intel introdujo el puerto AGP (Accelerated Graphics Port), diseñado para solucionar los cuellos de botella entre el procesador y la tarjeta gráfica, mejorando notablemente el rendimiento. Posteriormente, en 2003, el PCI Express reemplazó al AGP, estableciéndose como el estándar dominante hasta la actualidad.

La Revolución de la GPU: Nvidia y la GeForce 256

A finales de los años 90, Nvidia revolucionó la industria con la creación de la GPU (Unidad de Procesamiento Gráfico). Este procesador dedicado a tareas gráficas, integrado en la tarjeta de video, permitió un salto cualitativo en la potencia de procesamiento. El lanzamiento de la GeForce 256 en 1999 marcó un hito histórico. Esta tarjeta fue capaz de procesar más de 10 millones de polígonos por segundo, abriendo nuevas posibilidades para la creación de videojuegos y aplicaciones 3D.

La incorporación de memorias DDR y el aumento de la capacidad de memoria (llegando a los 128 MB) en años posteriores contribuyó a la mejora continua del rendimiento. Nvidia y AMD se consolidaron como las empresas dominantes en el mercado, con sus series GeForce y Radeon, respectivamente.

El Presente y el Futuro: 8K y la Inteligencia Artificial

Actualmente, las tarjetas gráficas soportan resoluciones de hasta 8K a 60 Hz, convirtiéndose en componentes esenciales para videojuegos, diseño 3D, edición de video, y otras aplicaciones exigentes. Ejemplos de tarjetas gráficas de alta gama incluyen la Nvidia RTX 2050 Super y la AMD RX 5700.

Más allá del entretenimiento, la capacidad de procesamiento paralelo de las GPUs ha encontrado una aplicación crucial en el campo de la Inteligencia Artificial. Su eficiencia en el procesamiento de grandes volúmenes de datos ha impulsado el desarrollo de algoritmos de aprendizaje profundo, convirtiendo a las GPUs en un componente fundamental para el desarrollo de la IA. La demanda de GPUs para este sector ha llevado a Nvidia a ser una de las empresas más valiosas del entorno.

Tabla Comparativa de Tarjetas Gráficas Pioneras:

| Tarjeta | Año | Características Clave |

|---|---|---|

| MDA | 1981 | Monocromático, 4 kB RAM |

| CGA | 1981 | Color, 16 KiB VRAM, 16 colores |

| HGC | 1982 | Alta resolución monocromática, 643 kB RAM |

| VGA | 1990 | 2 MB VRAM, 256 colores |

| GeForce 256 | 1999 | Primera GPU, más de 10 millones de polígonos/segundo |

Consultas Habituales:

- ¿ Cuál fue la primera tarjeta gráfica? La MDA (Monochrome Display Adapter) en 198

- ¿ Quién inventó la GPU? Nvidia es reconocida por el desarrollo y popularización de la GPU.

- ¿ Cuál fue la primera tarjeta gráfica de Nvidia? La GeForce 256 en 199

La historia de las tarjetas gráficas es una muestra de la innovación constante en el entorno de la tecnología. Desde sus humildes comienzos hasta su papel esencial en la era de la inteligencia artificial, estas tarjetas han sido un motor fundamental del progreso tecnológico y la experiencia de usuario.