21/09/2016

La distribución F de Fisher, nombrada en honor al estadístico Sir Ronald Fisher, es una herramienta fundamental en el análisis de la varianza (ANOVA) y otras pruebas estadísticas. Esta distribución, representada gráficamente, permite evaluar la significancia de las diferencias entre las varianzas de dos o más grupos de datos. Este artículo profundiza en la comprensión y aplicación de la gráfica F de Fisher.

¿Qué indica la F de Fisher ?

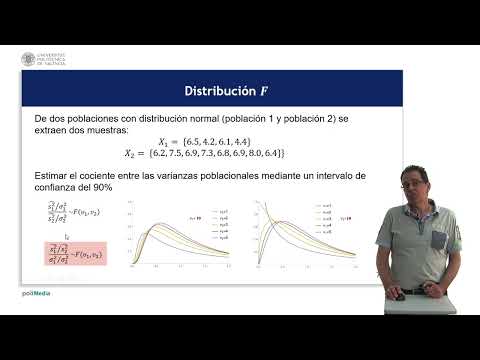

El estadístico F es un cociente, una fracción que resulta de la comparación de dos estimaciones de varianza: la varianza entre muestras y la varianza dentro de las muestras. Cada varianza tiene sus propios grados de libertad, representando la cantidad de información independiente utilizada en su cálculo. Si F ~ F 4,10, significa que la distribución F tiene 4 grados de libertad en el numerador y 10 en el denominador.

Importancia de la Distribución F : La distribución F se deriva de la distribución t de Student, ampliando la prueba t para comparar más de dos grupos. Utilizar ANOVA en lugar de múltiples pruebas t por pares minimiza el riesgo de cometer un error de tipo I (rechazar la hipótesis nula cuando es verdadera).

Cálculo del Estadístico F

El cálculo del estadístico F se basa en la estimación de dos varianzas:

- Varianza entre muestras (o varianza explicada): Estima la variabilidad entre las medias de los diferentes grupos. Se calcula considerando el tamaño de las muestras (ponderado si son diferentes).

- Varianza dentro de las muestras (o varianza no explicada): Estima la variabilidad dentro de cada grupo. Es el promedio de las varianzas de cada muestra (ponderado si los tamaños muestrales varían).

Para calcular estas varianzas, se utilizan las sumas de cuadrados (SS):

- SS entre: Suma de cuadrados que representa la variación entre los grupos.

- SS dentro: Suma de cuadrados que representa la variación dentro de los grupos, debida al azar.

- SS total: Suma de cuadrados total, representando la variación total en los datos (SS total = SS entre + SS dentro).

A partir de las sumas de cuadrados, se calcula la media cuadrática (MS):

- MS entre: Varianza entre grupos (MS entre = SS entre / grados de libertad entre).

- MS dentro: Varianza dentro de los grupos (MS dentro = SS dentro / grados de libertad dentro).

Finalmente, el estadístico F se calcula como:

F = MS entre / MS dentro

Los grados de libertad son:

- Grados de libertad entre (numerador): df entre = k - 1, donde k es el número de grupos.

- Grados de libertad dentro (denominador): df dentro = n - k, donde n es el tamaño total de la muestra.

Tabla ANOVA

Los resultados del ANOVA se suelen presentar en una tabla como la siguiente:

| Fuente de Variación | Suma de Cuadrados (SS) | Grados de Libertad (df) | Media Cuadrática (MS) | F |

|---|---|---|---|---|

| Factor (entre) | SS(factor) | k - 1 | MS(factor) = SS(factor)/(k - 1) | F = MS(Factor)/MS(Error) |

| Error (dentro) | SS(error) | n - k | MS(error) = SS(error)/(n - k) | |

| Total | SS(total) | n - 1 |

Donde:

- k es el número de grupos.

- n es el número total de observaciones.

Interpretación del Estadístico F

Bajo la hipótesis nula (H0), que establece que no hay diferencias significativas entre las medias de los grupos, el estadístico F debe ser cercano a Si H0 es falsa (hay diferencias significativas), MS entre será mayor que MS dentro, resultando en un valor F significativamente mayor que

Para determinar la significancia estadística, se compara el valor calculado de F con el valor crítico de F obtenido de una tabla de distribución F para un nivel de significancia α (usualmente 0.05) y los grados de libertad correspondientes. Si el valor calculado de F es mayor que el valor crítico, se rechaza H0.

El valor p, también obtenido de la tabla de distribución F, representa la probabilidad de obtener un valor de F tan extremo o más extremo que el observado, asumiendo que H0 es verdadera. Si el valor p es menor que α, se rechaza H0.

Diferencias entre la Prueba F y la Prueba Exacta de Fisher

La prueba exacta de Fisher es una alternativa a la prueba Chi-cuadrado, especialmente útil cuando se trabaja con tablas de contingencia de pequeñas dimensiones o con frecuencias esperadas bajas (menores a 5). A diferencia de la prueba F, que se usa principalmente en ANOVA para comparar varianzas entre grupos, la prueba exacta de Fisher evalúa la independencia entre dos variables categóricas. Ambas pruebas tienen como objetivo determinar si existe una relación estadísticamente significativa entre las variables, pero sus aplicaciones y métodos de cálculo difieren significativamente.

Aplicaciones de la Gráfica F de Fisher

La gráfica F de Fisher tiene amplias aplicaciones en diversas áreas, incluyendo:

- ANOVA de un factor: Para comparar las medias de tres o más grupos.

- ANOVA de dos factores: Para analizar la interacción entre dos factores y sus efectos sobre la variable dependiente.

- Análisis de regresión: Para evaluar la significancia de los modelos de regresión.

- Análisis de datos experimentales: Para determinar si las diferencias observadas entre los grupos son estadísticamente significativas.

La distribución F de Fisher es una herramienta poderosa para el análisis estadístico. Su correcta comprensión e interpretación son cruciales para la toma de decisiones basadas en evidencia en una amplia gama de campos. Dominar el cálculo y la interpretación del estadístico F permite realizar análisis de varianza robustos y sacar conclusiones significativas a partir de los datos.